Make.com을 이용해 SNS부터 EC사이트 까지 모든 사이트 웹 크롤링 스크레이핑 하기

저는 Make.com 를 주식의 자동매매와 AI를 이용한 자동 블로그 작성 용도로 사용 하고 있습니다.

지금도 충분히 지불하는 비용에 비하면 만족하고 있습니다만 Make.com의 요금제는 자동화 횟수(Operations)를 구매하고 매달 초기화 된 후에 리필이되는 방식이기 때문에 매달 낭비되는 비용이 발생합니다.

그렇기 때문에 하나쯤 '꼭 자동화를 해야할 정도는 아니지만 자동화를 해두면 편한' 그런 작업 시나리오가 있다면 알뜰하게 비용을 소모 할수 있습니다.

그리고 그런 목적에 딱 맞는 용도가 있는데요 . 바로 웹 크롤링 스크레이핑 분야입니다.

이번에는 제가 실제로 사용하고 있는 시나리오를 대상으로 Make.com을 어떻게 설정 하면 정보를 취득하고 그 정보를 축적해갈수 있는지 공유하겠습니다.

사용 예시

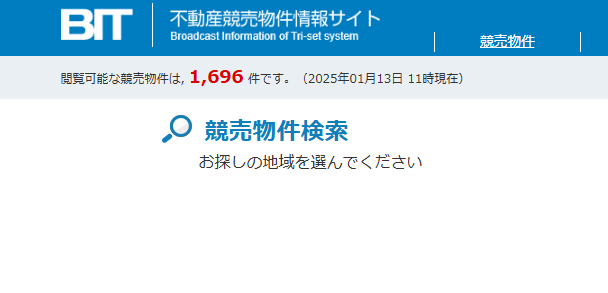

- 크롤링 대상 사이트

일본 법원 경매 부동산 사이트 - 모니터링 목적

홈페이지 내부에는 잔여 부동산 수가 표시됩니다. 이 수치는 파산 등의 절차로 인해 법원 경매 사이트에 부동산이 등록되었으나 아직 낙찰되지 않은 부동산의 총합입니다. 이 숫자를 모니터링함으로써 일본의 부동산 경기를 좀 더 빠르게 추적할 수 있을 것 같아, 그래서 크롤링을 시작하게 되었습니다.

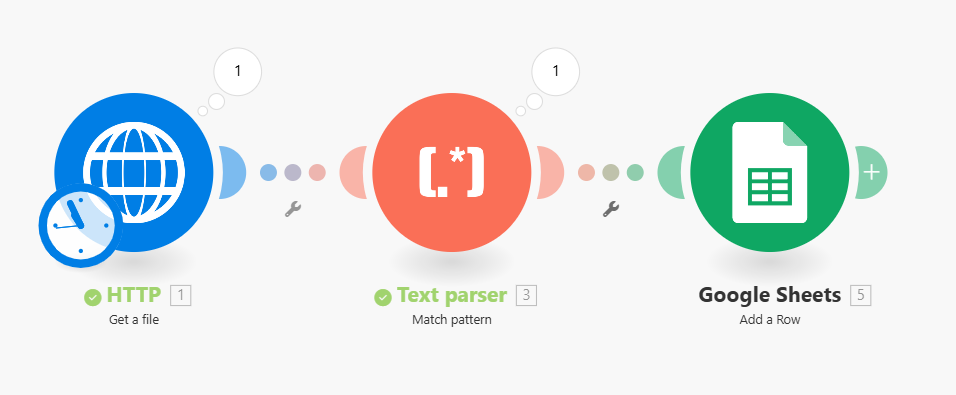

Make.com 설계

- HTTP (Get a file)

해당 홈페이지의 URL을 입력하면 HTML 코드를 받아옵니다. - Text Parser (Match Pattern)

취득한 HTML 코드 내부에서 원하는 태그의 내부 정보만 추출하기 위해 정규식을 사용합니다.

이번 케이스에서는<span class="bit__info_text_red mx-1">1,696</span>

태그 내부의1,696숫자만 가져오면 되므로, 아래와 같은 정규식을 사용합니다.

Pattern:<span class="bit__info_text_red mx-1">([\d,]+)</span> - Google Spreadsheet에 입력

취득한 데이터와 타임스탬프( Make.com의 now 함수를 사용 )를 Google 스프레드시트에 입력합니다.

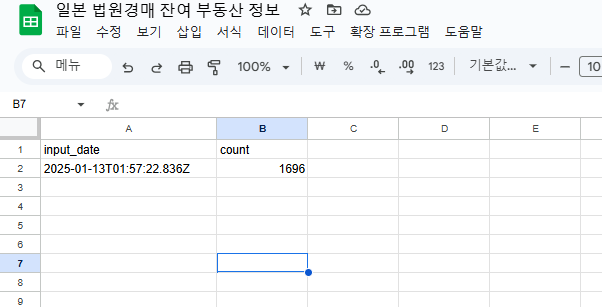

실행 결과

데이터 취득에 성공했으므로, 위의 자동화 흐름을 일정에 따라 실행하면 모든 작업이 완료됩니다.

마무리

이번 케이스는 설명을 위해 상당히 간략하게 구성했지만, 목적에 따라 다양한 방식으로 활용할 수 있습니다.

예를 들어, 데이터를 Google Spreadsheet가 아닌 메신저로 출력하도록 설정하면 예약이 필요한 특정 사이트에서 취소가 발생했을 때 바로 알림을 받을 수 있습니다. 또는 ChatGPT를 활용해 원하는 정보를 더 쉽고 동적으로 취득하는 것도 가능합니다.

다양한 웹 크롤링 및 스크레이핑 툴이 존재하지만, 굳이 이 방법을 선택해야 하는 이유가 궁금하신 분도 계실 겁니다. 이를 보충하자면, 웹 크롤링 및 스크레이핑의 핵심은 단순히 데이터를 취득하는 것이 아니라 스케줄링에 있습니다.

이를 위해 스스로 데이터 취득용 단말을 돌려 24시간 가동해야 하는데, 이에 비해 Make.com의 우수한 자동화 기능은 압도적으로 편리합니다. 물론 일부 자동 스케줄링 기능을 지원하는 웹 서비스도 존재하지만, 이러한 서비스는 간편하더라도 비용이 과도하게 높거나 데이터 취득 후 처리 기능이 제한적인 경우가 많습니다.

이 방법이 쉽지는 않지만, 효과적인 방법임은 확실합니다. 한 번 자신만의 크롤링 시스템을 설계해보는 건 어떨까요?